Aktualizováno v srpnu 2025 | Tým UNIKUM

Indexace stránek je pravděpodobně tou nejzásadnější záležitostí pro každý web, jelikož pokud se stránky nenacházejí v indexu žádného z vyhledávačů, pak v podstatě jako by vůbec neexistovaly a jsou okolnímu světu neviditelné. S neindexovanými stránkami se často, kromě nových webů, potýkají především webové projekty pracující s velkým objemem URL, kde navíc dochází k časté tvorbě nového obsahu. To, že je totiž nová stránka přidána na web neznamená, že dojde k jejímu okamžitému zaznamenání vyhledávači, jelikož na indexaci stránek má vliv několik faktorů. Nejdříve si však trochu osvětleme, co vlastně indexace webu znamená a co vše tento proces zahrnuje.

Indexace a crawling webu

Pro procházení webu využívají vyhledávače tzv. crawlery (roboty), které automaticky objevují a načítají obsah stránek. V případě Googlu je to především Googlebot (v mobilní nebo desktopové variantě), u Seznamu pak SeznamBot. Tito roboti procházejí internet podle odkazů, které najdou, a podle map stránek (sitemap), případně jim lze nové adresy zasílat prostřednictvím API či nástrojů pro webmastery.

Jakmile robot stránku navštíví a stáhne její obsah, následuje proces indexace, kdy je obsah analyzován, zpracován a uložen do databáze vyhledávače (tzv. indexu). V indexu jsou stránky organizovány tak, aby mohly být rychle vyhledány a přiřazeny k relevantním dotazům uživatelů.

Po indexaci probíhá tzv. hodnocení relevance (ranking), při kterém algoritmy vyhledávače posuzují, jak moc odpovídá obsah stránky konkrétnímu vyhledávacímu dotazu. Na základě stovek různých faktorů pak algoritmus určí, na jaké pozici ve výsledcích vyhledávání se stránka zobrazí.

Pokud bychom tedy měli pojem indexace vysvětlit jednoduše a zároveň přesně, znamená to přidání obsahu stránky do databáze vyhledávače, čímž se stránka stává dostupnou pro vyhledávací dotazy uživatelů.

Co ovlivňuje indexaci webu?

Aby mohl být web zaindexován, tak musí být v první řadě přístupný pro roboty vyhledávačů, aby mohly jeho obsah procházet v rámci crawlingu. U velkých webů pak hraje roli také limit, který mají roboti nastaven pro pravidelné procházení každého webu nastaven tzv crawl budget. Toto se však týká pouze webů pracujících s objemem URL v rámci vyšších desetitisíců URL a dále. Následující body se však mohou týkat i obyčejného osobního blogu:

1) Nastavení souboru robots.txt

Robots.txt je textový soubor, nacházející se vždy (pokud existuje) na www.vasedomena.cz/robots.txt, který obsahuje pokyny robotům vyhledávačů ohledně procházení vašeho webu. Typicky jsou zde zakázány přístupy do administrativního prostředí (například pro WordPress viz obrázek níže) nebo indexace stránek tvořených dotazy interního vyhledávání.

Na obrázku výše je pro ukázku nastaveno, že všichni roboti mají zákaz přistupovat do obsahu adresáře /wp-admin/ na dané doméně. Velice snadno se však může stát, že je v robots.txt zakázáno nedopatřením procházení celého webu.

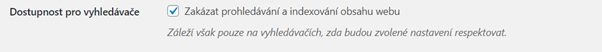

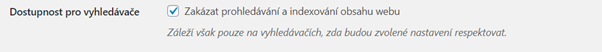

Pokud váš web běží na WordPressu, tak zde lze například zakázat kompletní procházení webu robotům a indexaci jediným kliknutím v sekci Nastavení – Zobrazování.

Pokud vás problematika robots.txt zajímá, tak se můžete dozvědět více v tomto návodu webu Jak psát web.

2) Meta tag robots

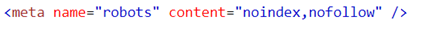

Zakázat indexaci lze kromě nastavení příslušných pravidel v robots.txt také přidáním kousku kódu do hlavičky stránky. Tímto způsobem však na rozdíl od hromadného pravidla v robots.txt dojde pouze k zamezení indexace jedné konkrétní stránky, na které se kód nachází.

Přeloženo do řeči lidí, tento kód říká robotům vyhledávačů, aby danou stránku neindexovaly a zároveň aby ani neprocházely odkazy z ní vedoucí.

Stránky, u kterých je indexace povolena a následování odkazů rovněž, by měly naopak obsahovat meta tag robots s následující hodnotu:

Nastavení tohoto tagu může mít jisté obměny, například je možné zakázat indexaci stránky, ale povolit následování odkazů (noindex,follow) či to udělat přesně naopak (index,nofollow). Nicméně nejběžněji používané jsou formy, které jsou uvedeny výše, jelikož je takto vygenerují i e-shopová řešení jako je Shoptet a další. Na oficiálním webu má projekt robots.txt zpracovanou dokumentaci, kterou si v případě zájmu můžete pročíst.

3) Neexistující či neaktualizovaný soubor sitemap.xml

Sitemap.xml, nebo-li mapa stránek, je soubor, který se standardně nachází na www.vasedomena.cz/sitemap.xml a jedná se prakticky o přehledný seznam URL adres, které se na webu nacházejí. Tento soubor je v mnoha případech vytvářen automaticky, pokud je pro tvorbu webu používáno krabicové e-shopové řešení či některý CMS systém. V takových případech je sitemapa i automaticky aktualizována a jsou do ní přidávány nově vytvořené stránky a již neexistují naopak odstraněny.

Zde můžeme vidět automatizovaně tvořenou sitemap skrze WordPress plugin (Yoast SEO)

Může se však stát, že u některých webů sitemap.xml neexistuje či neobsahuje aktuální URL adresy. To však neznamená, že by byl web nedostupný pro roboty a nedocházelo tak k indexaci. Jak je uvedeno na oficiálním webu sitemaps.org, existence sitemapy pomáhá pouze usnadnit práci robotům a není žádnou zárukou toho, že k indexaci stránek dojde. Nicméně tím, že budeme sitemapu mít, se zvyšuje šance, že k indexaci dojde. Neexistující sitemapa pak může být problémem hlavně pro opravdu velké weby jelikož zde může dojít k vyčerpání limitu na procházení, který mají roboti k dispozici bez toho, aniž by nové URL byly objeveny.

Obecně větším problémem však je, když nedochází k její aktualizaci, jelikož v ní pak mohou zůstat nechtěné URL adresy vedoucí na již neexistují stránky, které pak mohou zůstat zaindexované a nějakou dobu vyskytovat ve výsledcích vyhledávání například na Googlu. Takovéto odkazy budou vracet chybovou hlášku 404 – nenalezeno, což není dobře vnímáno jak z hlediska uživatelské, tak ani z hlediska vyhledávačů, které to mohou vnímat jako jistou známku neduhů webu.

Poslední výhodou sitemapy je, že pomáhají řešit problém s osamocenými stránkami na webu, na které nějakou náhodou nevedou žádné odkazy a roboti je tak nemohou objevit. Tím, že se však jejich URL adresy nachází v sitemapě, se stávají dostupné i pro roboty a mohou být indexovány.

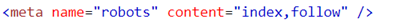

4) Na danou stránku v rámci webu nevedou žádné odkazy

Jak již bylo zmíněno v předchozím bodě, to, že není stránka indexována může být jednoduše způsobeno tím, že na ní nevedou žádné odkazy a nebo na ní vedou odkazy, které jsou až příliš hluboko zanořené v informační architektuře. Pokud se vám tedy zdá, že je stránka nezaindexovaná zcela bezdůvodně, zkuste si, jestli je možné se k ní vůbec proklikat. Toto může být značně úmorná práce, takže je lepší využít například nástroj Screamig Frog, který dokáže projít celý web a kromě velkého množství dalších údajů vrátí pro každou URL také informace o Crawl Depth, což je nutný počet kliknutí, který musí uživatel učinit, aby se na příslušnou stránku proklikal z úvodní stránky webu.

Pokud je stránka zcela osamocená a nebo má velice vysokou hodnotu Crawl Depth, pak je nutné na ni začít z příslušných stránek odkazovat, přičemž je dobré si pamatovat, že čím výše se bude odkaz nacházet (nejsilnější bude přímo z úvodní stránky webu), tím rychleji roboti vyhledávačů stránku objeví.

Jak zjistím, že jsou moje webové stránky indexované?

Zjistit počet indexovaných stránek lze několik způsoby, které se lehce liší vyhledávač od vyhledávače. Uvedu zde 3 způsoby, jak zjistit stav indexace vašich stránek. Pokud zkusíte všechny způsoby, tak je velice pravděpodobné, že se počty indexovaných stránek jednotlivých výstupů budou do určité míry lišit, což je způsobeno především lehce odlišným fungováním nástrojů. Kapitolou sama pro sebe je pak interní fungování každého z vyhledávačů a proto je velice běžné, že pokud jsou vaše stránky zaindexovány na Googlu, tak nemusí být hned samozřejmě indexované i na Seznam atp.

1) Zjištění indexace pomocí vyhledávacích operátorů

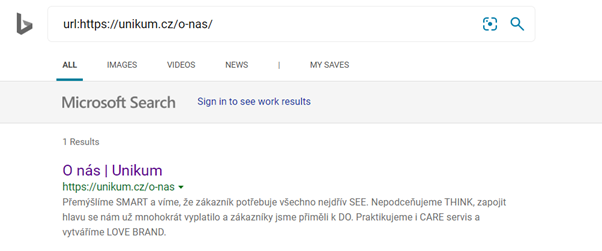

Zda-li jsou jednotlivé URL indexované lze zjistit zadáním speciálním operátoru do vyhledávání. Pro Seznam se jedná o operátor info: (například info:https://www.vasedomena.cz/uvod), který dříve podporoval i Google.

Bing pak používá operátor url: (url: https://www.vasedomena.cz/uvod)

Vzhledem, že operátor info: je již pro Google nefunkční, se nabízí alternativa v podobě jednoduchého zadání URL adresy do vyhledávání. Pokud se pak objeví ve výsledcích vyhledávání na prvním místě, tak je URL adresa indexovaná.

Nicméně lze využít jiného operátoru a to site:, který vrátí všechny URL (i počet), které se v indexu nacházejí.

2) Zjištění počtu indexovaných stránek v nástrojích vyhledávačů pro webmastery

Velice efektivně a snadno zjistíte kolik stránek vyhledávače evidují v jejich indexu pomocí jejich vlastních nástrojů pro webmastery, které mimo to nabízejí ještě další užitečné funkce pro monitoring webu. Účet si pro každý nástroj můžete snadno vytvořit bezplatně.

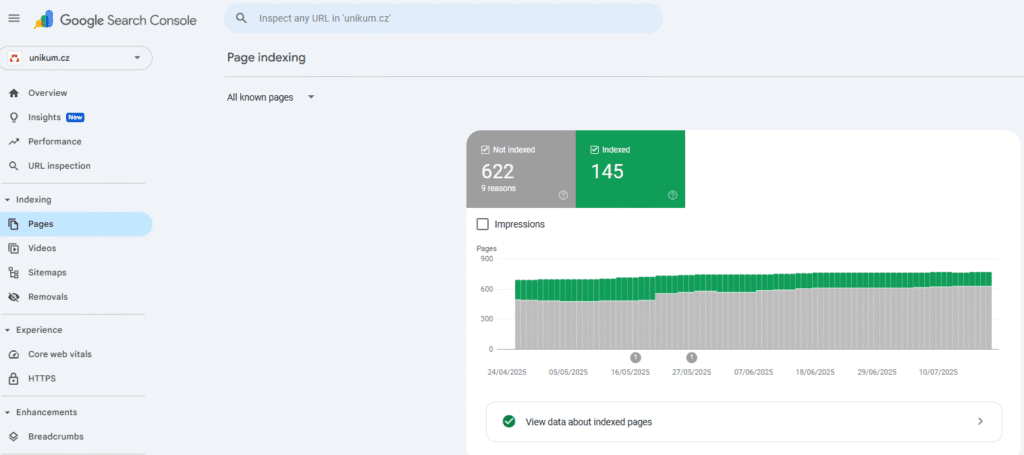

Google Search Console

Pro přihlášení přejděte v menu po levé straně do sekce Index a vyberte možnost Coverage. Následně uvidíte přehled URL vašeho webu rozdělený podle toho, zda jsou URL validní a nebo jsou z nějakého důvodu z indexu vyřazeny. U vyřazených URL pak Google Search Console ukáže i co jejich vyřazení způsobuje (například nasazený meta robots noindex tag) společně s výčtem URL adres, kterých se to týká. Účet založíte zde.

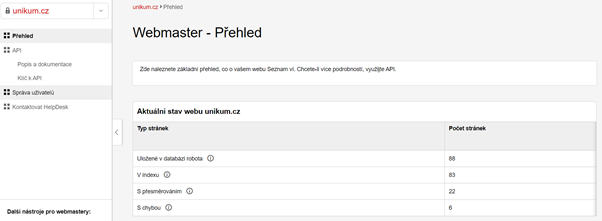

Seznam Webmaster

Český vyhledávač má také svůj vlastní nástroj pro monitorování webu. I přesto, že nenabízí zdaleka tolik funkcí jako nástroj od Googlu, tak zde alespoň základní přehled o indexaci naleznete. Bohužel však v administraci nástroje neuvidíte konkrétní URL adresy. Stav indexace je zobrazen hned v úvodním přehledu po vstupu do účtu do vašeho webu. Účet je možné založit zde.

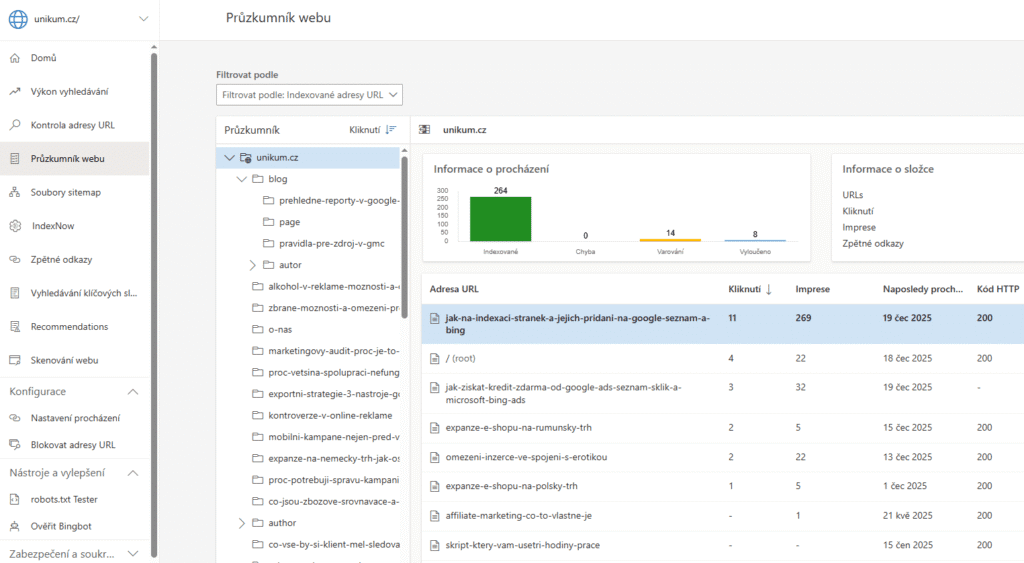

Binq Webmaster Tools

Pokud vás bude zajímat, jak si váš web stojí na Binqu, tak doporučuji založit účet i zde. Tento nástroj nabízí překvapivě asi největší množství funkcí ze všech zmíněných. Kromě ověření stavu indexace Bing Webmaster Tools mimo jiné poskytne možnost skenování webu, informaci o zpětných odkazech a další užitečné nástroje. Bing Webmaster Tools nabízí trochu jiný pohled na indexaci a místo většího přehledu v číslech můžete web procházet po adresář a dívat se, jak Bing váš web vnímá a jaké stránky indexuje. Toto je možné pomocí průzkumníku webu, který se nachází v hlavním panelu po levé straně viz následující obrázek:

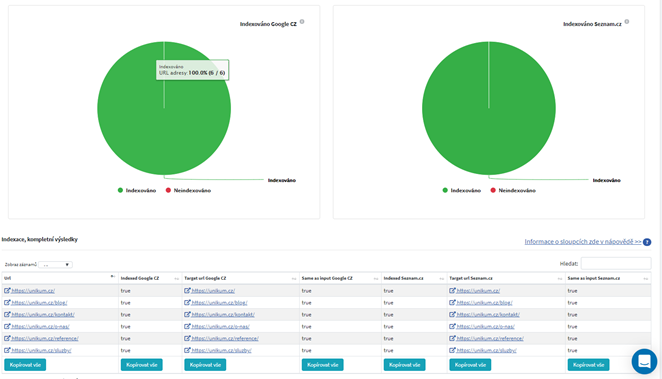

3) Zjištění indexaci pomocí ostatních nástrojů

Pokud budete chtít zjistit stav indexace pro vetší seznamy URL, bude pravděpodobně nejefektivnějším volbou sáhnout po nástrojích jako je Marketing Miner nebo Collabim. Oba nástroje nabízí základní účty zdarma a kromě analýzy indexace nabízí množství dalších funkcí.

V Collabimu, který osobně používám nejvíce, stačí zvolit mezi jednorázovými analýzami Analýzu URL, vložit seznam URL adres a poté už je zaškrtnout pro jakou zemi a vyhledávače chcete stav indexace ověřit. Výsledek analýzy pak vypadá následovně:

Co dělat, když moje stránka není indexovaná?

V případě, že zjistíte, že některé stránky vašeho webu nejsou indexované doporučuji v první řadě projít body ze sekce Co ovlivňuje indexaci webu, především pak nastavení robots.txt a hodnotu meta tagu robots. V případě, že indexace není robots zakázána, pak existuje způsob, jak manuálně přidat stránku do vyhledávačů, respektive požádat o její indexaci a učinit ji prioritní pro procházení roboty. Postup je téměř totožná pro Google, Seznam i Bing.

Jak přidat stránku do Googlu

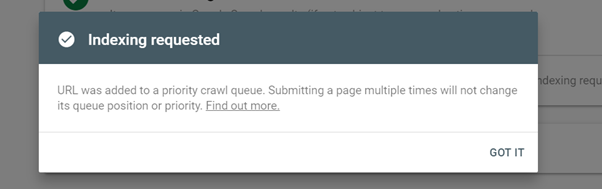

Do Google přidáte stránku tak, že se přihlásíte do Google Search Console, kde následně vyberete v menu po levé straně URL Inspection, do horního řádku zadáte požadovanou URL adresu a poté zvolíte možnost Request Indexing viz screenshot:

Následně by se vám měla po chvíli načítání objevit následující hláška, potvrzující, že URL byla přiřazena priorita při procházení webu:

Změna samozřejmě nenastane okamžitě, takže doporučuji stav indexace zkontrolovat nejdříve až následující den.

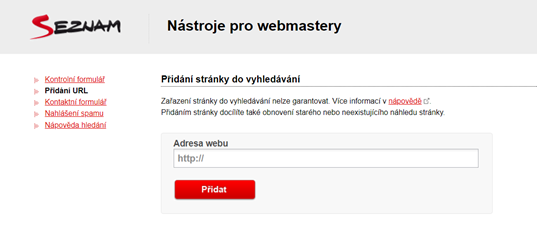

Jak přidat URL do Seznamu

Přidat URL do Seznamu můžete opět pomocí nástroje Seznam Webmaster, kde po přihlášení v levém sloupci vyberete možnost Přidání URL do hledání a následně se vám zobrazí následující stránka, kde stačí pouze zadat požadovanou URL adresu.

Stejně jako u Googlu zde můžete přidávat URL pouze po jedné, avšak pro hromadné předávání existuje pro e-shopy ještě jedna možnost a tou je aplikace Seznam Index Checker k českému nástroji pro správu XML feedů Mergado. V případě, že váš web trápí velké množství neindexovaných stránek na Seznamu, pak právě tohle může být řešením, avšak tuto možnost budou volit spíše velké webové projekty. Nicméně Mergado se Seznam Index Checkerem lze vyzkoušet zdarma a jediné co je potřeba, je vygenerovaný XML feed a aplikace pak díky dodaným URL adresám zjistí stav indexace a neindexované adres předá pomocí API k indexaci.

Jak přidat stránku na Bing

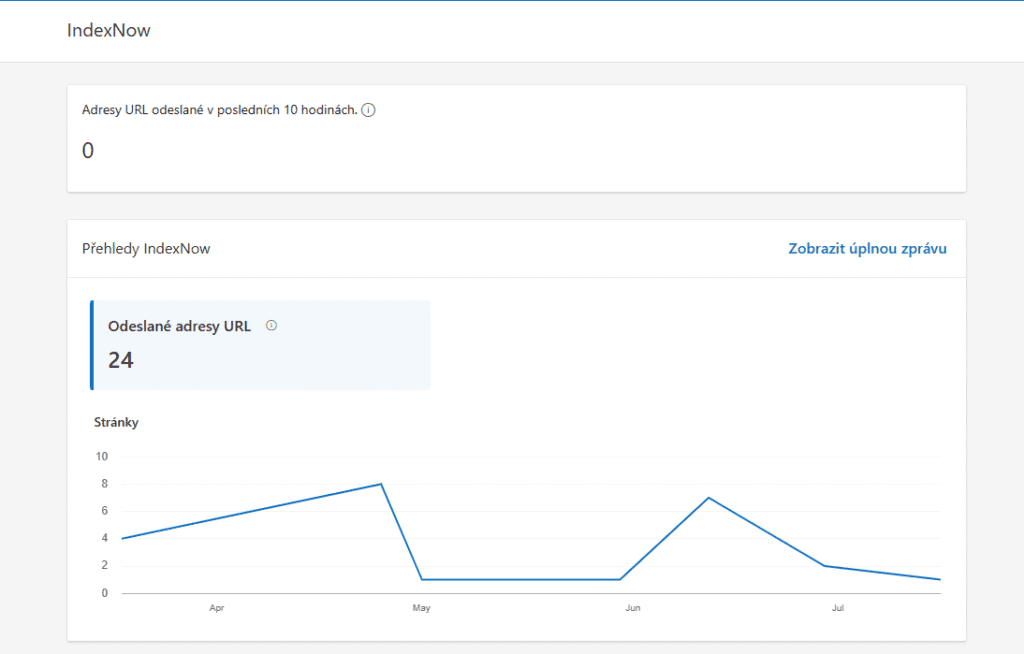

Na Microsoft Webmaster Tools se přidávají chybějící URL pomocí IndexNow, který je možný implementovat na mnoho šablonových řešení jako je např. Shopify. V případě, že žádné z nabízených šablonových řešení nevyužíváte, tak je možné si vytvořit jednoduchý spreadsheet pro odesílání stránek k indexaci. Informace o odeslaných URL budete mít přímo ve Webmaster Tools viz printscreen.

Závěr

Jak je patrné, tak indexace webu může být značně zapeklitou věcí, která je naprosto kritická pro úspešnost vašeho webu, jelikož neindexovaný web, jak kdyby prakticky neexistoval. Doufám, že vám tento článek pomohl problematiku nastínit a s neindexovanými stránkami si teď dokážete poradit. Pokud si však dál nevíte rady a nebo vás trápí nějaký další SEO problém, tak nás rozhodně neváhejte kontaktovat a v UNIKUM vám rádi poradíme.